Les processus de Markov ont été développés par des scientifiques en 1907. Les principaux mathématiciens de cette époque ont développé cette théorie, certains d'entre eux l'améliorent encore. Ce système s'étend également à d'autres domaines scientifiques. Les chaînes de Markov pratiques sont utilisées dans divers domaines où une personne doit arriver dans un état d'attente. Mais pour bien comprendre le système, vous devez connaître les termes et les dispositions. Le caractère aléatoire est considéré comme le facteur principal qui détermine le processus de Markov. Certes, ce n'est pas similaire au concept d'incertitude. Il a certaines conditions et variables.

Caractéristiques du facteur de hasard

Cette condition est soumise à la stabilité statique, plus précisément à ses régularités, qui ne sont pas prises en compte en cas d'incertitude. À son tour, ce critère permet l'utilisation de méthodes mathématiques dans la théorie des processus de Markov, comme l'a noté un scientifique qui a étudié la dynamique des probabilités. L'œuvre qu'il a créée traitait directement de ces variables. À son tour, le processus aléatoire étudié et développé, qui a les concepts d'état et detransition, ainsi que dans les problèmes stochastiques et mathématiques, tout en permettant à ces modèles de fonctionner. Entre autres choses, il offre l'opportunité d'améliorer d'autres sciences appliquées théoriques et pratiques importantes:

- théorie de la diffusion;

- théorie des files d'attente;

- théorie de la fiabilité et autres;

- chimie;

- physique;

- mécanique.

Caractéristiques essentielles d'un facteur imprévu

Ce processus de Markov est piloté par une fonction aléatoire, c'est-à-dire que toute valeur de l'argument est considérée comme une valeur donnée ou une valeur qui prend une forme pré-préparée. Exemples:

- oscillations dans le circuit;

- vitesse de déplacement;

- rugosité de surface dans une zone donnée.

Il est également communément admis que le temps est le fait d'une fonction aléatoire, c'est-à-dire que l'indexation se produit. Une classification a la forme d'un état et d'un argument. Ce processus peut être à états ou à temps discrets ou continus. De plus, les cas sont différents: tout se passe soit sous une forme, soit sous une autre, soit simultanément.

Analyse détaillée du concept de hasard

Il était assez difficile de construire un modèle mathématique avec les indicateurs de performance nécessaires sous une forme clairement analytique. À l'avenir, il est devenu possible de réaliser cette tâche, car un processus aléatoire de Markov est apparu. En analysant ce concept en détail, il est nécessaire d'en déduire un certain théorème. Un processus de Markov est un système physique qui a changé deune position et une condition qui n'ont pas été préprogrammées. Ainsi, il s'avère qu'un processus aléatoire s'y déroule. Par exemple: une orbite spatiale et un vaisseau qui y est lancé. Le résultat n'a été obtenu qu'en raison de certaines inexactitudes et ajustements, sans lesquels le mode spécifié n'est pas implémenté. La plupart des processus en cours sont inhérents au hasard, à l'incertitude.

Sur le fond, presque toutes les options envisageables seront soumises à ce facteur. Un avion, un appareil technique, une salle à manger, une horloge - tout cela est sujet à des changements aléatoires. De plus, cette fonction est inhérente à tout processus en cours dans le monde réel. Cependant, tant que cela ne s'applique pas aux paramètres réglés individuellement, les perturbations qui se produisent sont perçues comme déterministes.

Le concept de processus stochastique de Markov

Concevoir tout dispositif technique ou mécanique, dispositif oblige le créateur à prendre en compte différents facteurs, notamment les incertitudes. Le calcul des fluctuations aléatoires et des perturbations survient au moment de l'intérêt personnel, par exemple lors de la mise en œuvre d'un pilote automatique. Certains des processus étudiés dans les sciences comme la physique et la mécanique le sont.

Mais y prêter attention et mener des recherches rigoureuses devrait commencer au moment où cela est directement nécessaire. Un processus aléatoire de Markov a la définition suivante: la probabilité caractéristique de la forme future dépend de l'état dans lequel il se trouve à un instant donné, et n'a rien à voir avec l'apparence du système. Donc donnéle concept indique que le résultat peut être prédit, en ne considérant que la probabilité et en oubliant le contexte.

Explication détaillée du concept

Pour le moment, le système est dans un certain état, il bouge et change, il est fondamentalement impossible de prédire ce qui va se passer ensuite. Mais, compte tenu de la probabilité, on peut dire que le processus sera terminé sous une certaine forme ou conserver la précédente. C'est-à-dire que l'avenir surgit du présent, oubliant le passé. Lorsqu'un système ou un processus entre dans un nouvel état, l'historique est généralement omis. La probabilité joue un rôle important dans les processus de Markov.

Par exemple, le compteur Geiger indique le nombre de particules, qui dépend d'un certain indicateur, et non du moment exact où il est arrivé. Ici, le critère principal est le ci-dessus. Dans l'application pratique, non seulement les processus de Markov peuvent être pris en compte, mais également des processus similaires, par exemple: les avions participent à la bataille du système, chacun étant indiqué par une couleur. Dans ce cas, le critère principal est à nouveau la probabilité. À quel moment la prépondérance en nombre se produira, et pour quelle couleur, est inconnue. C'est-à-dire que ce facteur dépend de l'état du système, et non de la séquence des décès d'avions.

Analyse structurelle des processus

Un processus de Markov est tout état d'un système sans conséquence probabiliste et sans égard à l'historique. Autrement dit, si vous incluez le futur dans le présent et omettez le passé. La sursaturation de ce temps avec la préhistoire conduira à la multidimensionnalité etaffichera des constructions complexes de circuits. Par conséquent, il est préférable d'étudier ces systèmes avec des circuits simples avec des paramètres numériques minimaux. Par conséquent, ces variables sont considérées comme déterminantes et conditionnées par certains facteurs.

Un exemple de processus de Markov: un dispositif technique fonctionnel qui est en bon état en ce moment. Dans cet état de choses, ce qui est intéressant, c'est la probabilité que l'appareil fonctionne pendant une période de temps prolongée. Mais si nous percevons l'équipement comme débogué, cette option n'appartiendra plus au processus considéré car il n'y a aucune information sur la durée de fonctionnement de l'appareil et si des réparations ont été effectuées. Cependant, si ces deux variables temporelles sont complétées et incluses dans le système, alors son état peut être attribué à Markov.

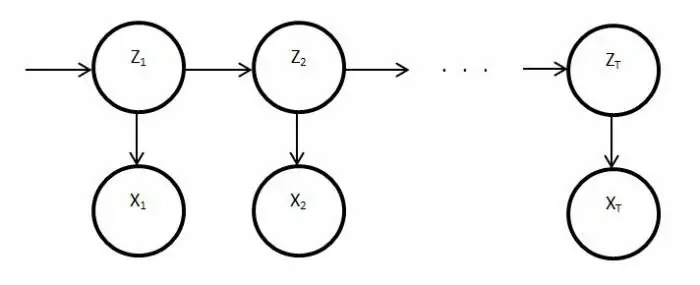

Description de l'état discret et de la continuité du temps

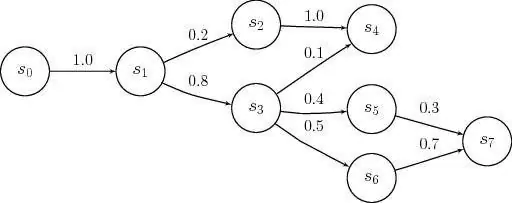

Les modèles de processus de Markov sont appliqués au moment où il faut négliger la préhistoire. Pour la recherche en pratique, les états discrets et continus sont le plus souvent rencontrés. Des exemples d'une telle situation sont les suivants: la structure de l'équipement comprend des nœuds qui peuvent tomber en panne pendant les heures de travail, et cela se produit comme une action aléatoire non planifiée. En conséquence, l'état du système subit la réparation de l'un ou l'autre élément, à ce moment l'un d'eux sera sain ou les deux seront débogués, ou vice versa, ils sont entièrement ajustés.

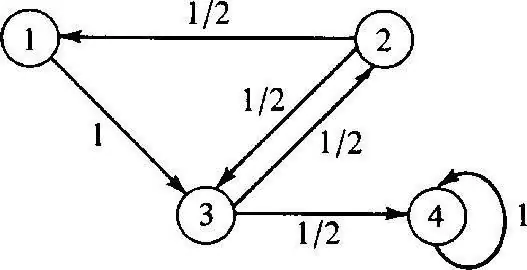

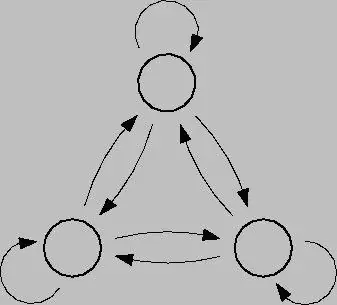

Le processus de Markov discret est basé sur la théorie des probabilités et est égalementpassage du système d'un état à un autre. De plus, ce facteur se produit instantanément, même en cas de pannes accidentelles et de travaux de réparation. Pour analyser un tel processus, il est préférable d'utiliser des graphes d'état, c'est-à-dire des diagrammes géométriques. Les états du système dans ce cas sont indiqués par différentes formes: triangles, rectangles, points, flèches.

Modélisation de ce processus

Les processus de Markov à états discrets sont des modifications possibles de systèmes résultant d'une transition instantanée, et qui peuvent être numérotées. Par exemple, vous pouvez construire un graphe d'état à partir de flèches pour les nœuds, où chacun indiquera le chemin des facteurs de défaillance dirigés différemment, l'état de fonctionnement, etc. À l'avenir, toutes les questions peuvent se poser: comme le fait que tous les éléments géométriques ne pointent pas dans le bon sens, car dans le processus, chaque nœud peut se détériorer. Lorsque vous travaillez, il est important de tenir compte des fermetures.

Le processus de Markov en temps continu se produit lorsque les données ne sont pas préfixées, cela se produit de manière aléatoire. Les transitions n'étaient pas prévues auparavant et se produisent par sauts, à tout moment. Dans ce cas, encore une fois, le rôle principal est joué par la probabilité. Cependant, si la situation actuelle est l'une des situations ci-dessus, un modèle mathématique sera nécessaire pour la décrire, mais il est important de comprendre la théorie de la possibilité.

Théories probabilistes

Ces théories considèrent probabiliste, ayant des caractéristiques telles queordre aléatoire, mouvement et facteurs, problèmes mathématiques, non déterministes, qui sont certains de temps en temps. Un processus de Markov contrôlé a et est basé sur un facteur d'opportunité. De plus, ce système est capable de passer instantanément à n'importe quel état dans diverses conditions et intervalles de temps.

Pour mettre cette théorie en pratique, il est nécessaire d'avoir une connaissance importante de la probabilité et de son application. Dans la plupart des cas, on est dans un état d'attente, ce qui, dans un sens général, est la théorie en question.

Exemples de théorie des probabilités

Des exemples de processus de Markov dans cette situation peuvent être:

- café;

- guichets;

- ateliers de réparation;

- stations à des fins diverses, etc.

En règle générale, les gens sont confrontés à ce système tous les jours, aujourd'hui on l'appelle faire la queue. Dans les installations où un tel service est présent, il est possible d'exiger diverses demandes, qui sont satisfaites dans le processus.

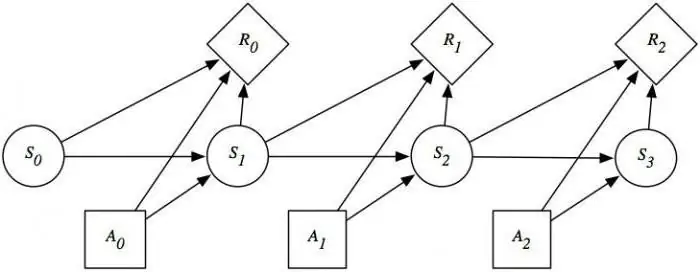

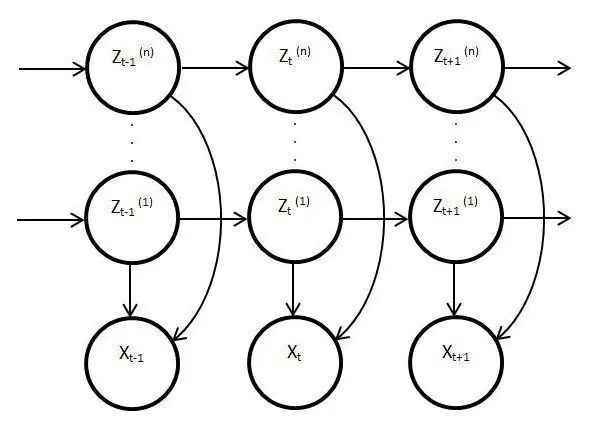

Modèles de processus cachés

Ces modèles sont statiques et copient le travail du processus original. Dans ce cas, la caractéristique principale est la fonction de surveillance des paramètres inconnus qui doivent être démêlés. Par conséquent, ces éléments peuvent être utilisés dans l'analyse, la pratique ou pour reconnaître divers objets. Les processus de Markov ordinaires sont basés sur des transitions visibles et sur la probabilité, seules des inconnues sont observées dans le modèle latentvariables affectées par l'état.

Divulgation essentielle des modèles de Markov cachés

Il a également une distribution de probabilité parmi d'autres valeurs, par conséquent, le chercheur verra une séquence de caractères et d'états. Chaque action a une distribution de probabilité parmi d'autres valeurs, de sorte que le modèle latent fournit des informations sur les états successifs générés. Les premières notes et références à celles-ci sont apparues à la fin des années soixante du siècle dernier.

Ensuite, ils ont été utilisés pour la reconnaissance vocale et comme analyseurs de données biologiques. De plus, des modèles latents se sont répandus dans l'écriture, les mouvements, l'informatique. De plus, ces éléments imitent le travail du processus principal et restent statiques, cependant, malgré cela, il existe des caractéristiques beaucoup plus distinctives. En particulier, ce fait concerne l'observation directe et la génération de séquences.

Processus de Markov stationnaire

Cette condition existe pour une fonction de transition homogène, ainsi que pour une distribution stationnaire, qui est considérée comme l'action principale et, par définition, aléatoire. L'espace des phases pour ce processus est un ensemble fini, mais dans cet état de choses, la différenciation initiale existe toujours. Les probabilités de transition dans ce processus sont considérées sous des conditions de temps ou d'éléments supplémentaires.

L'étude détaillée des modèles et processus de Markov révèle la question de la satisfaction de l'équilibre dans divers domaines de la vieet les activités de la société. Étant donné que cette industrie affecte la science et les services de masse, la situation peut être corrigée en analysant et en prédisant le résultat de tout événement ou action des mêmes montres ou équipements défectueux. Pour utiliser pleinement les capacités du processus de Markov, il convient de les comprendre en détail. Après tout, cet appareil a trouvé une large application non seulement dans la science, mais aussi dans les jeux. Ce système dans sa forme pure n'est généralement pas pris en compte, et s'il est utilisé, alors uniquement sur la base des modèles et schémas ci-dessus.